文章推荐

Java7/8 中的 HashMap 和 ConcurrentHashMap 全解析 (javadoop.com)

源码分析

HashMap

基本属性(阈值&系数&容量)

public class HashMap<K,V> extends AbstractMap<K,V>

implements Map<K,V>, Cloneable, Serializable {

@java.io.Serial

private static final long serialVersionUID = 362498820763181265L;

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4;

static final int MAXIMUM_CAPACITY = 1 << 30;

static final float DEFAULT_LOAD_FACTOR = 0.75f;

static final int TREEIFY_THRESHOLD = 8;

static final int UNTREEIFY_THRESHOLD = 6;

static final int MIN_TREEIFY_CAPACITY = 64;

transient Node<K,V>[] table;

transient Set<Map.Entry<K,V>> entrySet;

transient int size;

transient int modCount;

int threshold;

final float loadFactor;

}

loadFactor负载因子

负载因子是控制数组存放数据的疏密程度,loadFactor越接近1,那么数组中存放的数据(entry)也就越多,否则就越少。

太大查找元素的效率低,太小利用率太低

所以默认 16 * 0.75 = 12,超过这个数据量时,就会进行扩容

threshold

threshold = capacity * loadFacotry,是数组扩容的标准

因为hashmap中没有capacity这个属a性,所以即使指定了初始化的capacity,也会被扩容到2的最接近这个大小的幂次方

Node 节点类源码

static class Node<K,V> implements Map.Entry<K,V> {

final int hash;

final K key;

V value;

Node<K,V> next;

Node(int hash, K key, V value, Node<K,V> next) {

this.hash = hash;

this.key = key;

this.value = value;

this.next = next;

}

public final K getKey() { return key; }

public final V getValue() { return value; }

public final String toString() { return key + "=" + value; }

public final int hashCode() {

return Objects.hashCode(key) ^ Objects.hashCode(value);

}

public final V setValue(V newValue) {

V oldValue = value;

value = newValue;

return oldValue;

}

public final boolean equals(Object o) {

if (o == this)

return true;

return o instanceof Map.Entry<?, ?> e

&& Objects.equals(key, e.getKey())

&& Objects.equals(value, e.getValue());

}}

树节点源码

static final class TreeNode<K,V> extends LinkedHashMap.Entry<K,V> {

TreeNode<K,V> parent;

TreeNode<K,V> left;

TreeNode<K,V> right;

TreeNode<K,V> prev;

boolean red;

}

hash方法

put

- 判断数组,若发现数组为空,则进行首次扩容。

- 判断头节点,若发现头节点为空,则新建链表节点,存入数组。

- 判断头节点,若发现头节点非空,则将元素插入槽内。

- 若元素的key与头节点一致,则直接覆盖头节点。

- 若元素为树型节点,则将元素追加到树中。

- 若元素为链表节点,则将元素追加到链表中。(追加后,需要判断链表长度以决定是否转为红黑树。若链表长度达到8、数组容量未达到64,则扩容。若链表长度达到8、数组容量达到64,则转为红黑树。)

- 插入元素后,判断元素的个数,若发现超过阈值则再次扩容。

put方法实际就是调用putVal,并且putVal用户不可直接使用public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

Node<K,V>[] tab; Node<K,V> p; int n, i;

if ((tab = table) == null || (n = tab.length) == 0)

n = (tab = resize()).length;

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

else {

Node<K,V> e; K k;

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

e = p;

else if (p instanceof TreeNode)

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

else {

for (int binCount = 0; ; ++binCount) {

if ((e = p.next) == null) {

p.next = newNode(hash, key, value, null);

if (binCount >= TREEIFY_THRESHOLD - 1)

treeifyBin(tab, hash);

break;

}

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

if (e != null) {

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

e.value = value;

afterNodeAccess(e);

return oldValue;

}

}

++modCount;

if (++size > threshold)

resize();

afterNodeInsertion(evict);

return null;

}

基本逻辑:

- 如果定位到的数组位置没有元素,则直接插入

- 如果有元素,就要与插入的key进行比较,如果相同,就覆盖。如果不同就判断p是否是树节点,如果不是就直接遍历链表插入,使用尾插法,否则调用putTreeVal函数

get

public V get(Object key) {

Node<K,V> e;

return (e = getNode(key)) == null ? null : e.value;

}

final Node<K,V> getNode(Object key) {

Node<K,V>[] tab; Node<K,V> first, e; int n, hash; K k;

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & (hash = hash(key))]) != null) {

if (first.hash == hash &&

((k = first.key) == key || (key != null && key.equals(k))))

return first;

if ((e = first.next) != null) {

if (first instanceof TreeNode)

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

resize

final Node<K,V>[] resize() {

Node<K,V>[] oldTab = table;

int oldCap = (oldTab == null) ? 0 : oldTab.length;

int oldThr = threshold;

int newCap, newThr = 0;

if (oldCap > 0) {

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

return oldTab;

}

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY && oldCap >= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1;

}

else if (oldThr > 0)

newCap = oldThr;

else {

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

if (newThr == 0) {

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ? (int)ft : Integer.MAX_VALUE);

}

threshold = newThr;

@SuppressWarnings({"rawtypes","unchecked"})

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

table = newTab;

if (oldTab != null) {

for (int j = 0; j < oldCap; ++j) {

Node<K,V> e;

if ((e = oldTab[j]) != null) {

oldTab[j] = null;

if (e.next == null)

newTab[e.hash & (newCap - 1)] = e;

else if (e instanceof TreeNode)

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

else {

Node<K,V> loHead = null, loTail = null;

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

do {

next = e.next;

if ((e.hash & oldCap) == 0) {

if (loTail == null)

loHead = e;

else

loTail.next = e;

loTail = e;

}

else {

if (hiTail == null)

hiHead = e;

else

hiTail.next = e;

hiTail = e;

}

} while ((e = next) != null);

if (loTail != null) {

loTail.next = null;

newTab[j] = loHead;

}

if (hiTail != null) {

hiTail.next = null;

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

ConcurrentHashMap

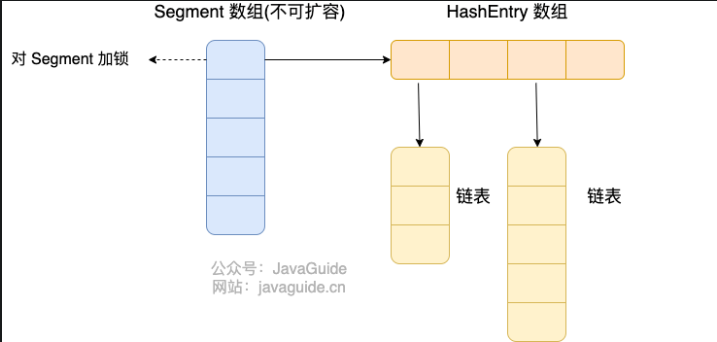

JDK1.7

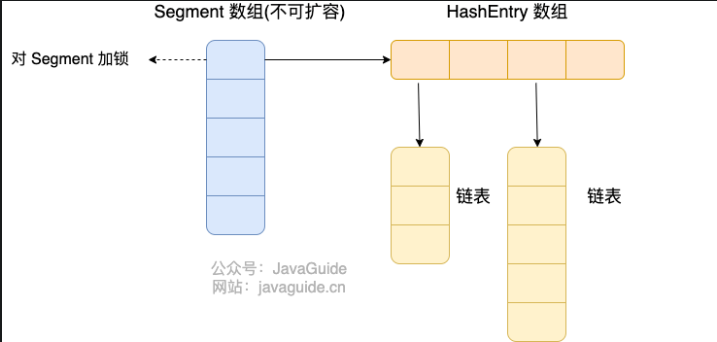

JDK1.7中,ConcurrentHashMap是由多个Segment组合,而每一个Segment都是一个类似于HashMap的结构,可以内部进行扩容,但是Segment的个数一旦初始化就不能改变了。默认支持16个,也就是默认支持16个线程并发 Segment 通过继承 ReentrantLock 来进行加锁

Segment 通过继承 ReentrantLock 来进行加锁

初始化

无参构造中调用了有参构造,传入三个默认值

static final int DEFAULT_INITIAL_CAPACITY = 16;

static final float DEFAULT_LOAD_FACTOR = 0.75f;

static final int DEFAULT_CONCURRENCY_LEVEL = 16;

初始化逻辑

@SuppressWarnings("unchecked")

public ConcurrentHashMap(int initialCapacity,float loadFactor, int concurrencyLevel) {

if (!(loadFactor > 0) || initialCapacity < 0 || concurrencyLevel <= 0)

throw new IllegalArgumentException();

if (concurrencyLevel > MAX_SEGMENTS)

concurrencyLevel = MAX_SEGMENTS;

int sshift = 0;

int ssize = 1;

while (ssize < concurrencyLevel) {

++sshift;

ssize <<= 1;

}

this.segmentShift = 32 - sshift;

this.segmentMask = ssize - 1;

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

int c = initialCapacity / ssize;

if (c * ssize < initialCapacity)

++c;

int cap = MIN_SEGMENT_TABLE_CAPACITY;

while (cap < c)

cap <<= 1;

Segment<K,V> s0 = new Segment<K,V>(loadFactor, (int)(cap * loadFactor),

(HashEntry<K,V>[])new HashEntry[cap]);

Segment<K,V>[] ss = (Segment<K,V>[])new Segment[ssize];

UNSAFE.putOrderedObject(ss, SBASE, s0);

this.segments = ss;

}

- 校验并发等级大小,如果大于最大值,就重置为最大值

- 初始化容量为大于并发等级最近的2的幂次方,默认16

- 记录segmentShift偏移量,2^n 中的n,默认为32 - sshift = 28

- 记录segmentMask,默认是ssize - 1 = 16 - 1 = 15

- 初始化

segment[0],默认大小为2,扩容阈值为 2 * 0.75 = 1.5。插入第二个值时才会进行扩容

put

public V put(K key, V value) {

Segment<K,V> s;

if (value == null)

throw new NullPointerException();

int hash = hash(key);

int j = (hash >>> segmentShift) & segmentMask;

if ((s = (Segment<K,V>)UNSAFE.getObject

(segments, (j << SSHIFT) + SBASE)) == null)

s = ensureSegment(j);

return s.put(key, hash, value, false);

}

@SuppressWarnings("unchecked")

private Segment<K,V> ensureSegment(int k) {

final Segment<K,V>[] ss = this.segments;

long u = (k << SSHIFT) + SBASE;

Segment<K,V> seg;

if ((seg = (Segment<K,V>)UNSAFE.getObjectVolatile(ss, u)) == null) {

Segment<K,V> proto = ss[0];

int cap = proto.table.length;

float lf = proto.loadFactor;

int threshold = (int)(cap * lf);

HashEntry<K,V>[] tab = (HashEntry<K,V>[])new HashEntry[cap];

if ((seg = (Segment<K,V>)UNSAFE.getObjectVolatile(ss, u)) == null) {

Segment<K,V> s = new Segment<K,V>(lf, threshold, tab);

while ((seg = (Segment<K,V>)UNSAFE.getObjectVolatile(ss, u))

== null) {

if (UNSAFE.compareAndSwapObject(ss, u, null, seg = s))

break;

}

}

}

return seg;

}

- 计算key的位置,获取指定位置的Segment

- 如果指定位置的Segment为空,则初始化这个Segment

- 如果为null,使用

Segment[0]的容量和负载因子创建一个HashEntry数组

- 再次检查是否为null

- 使用HashEntry初始化这个Segment

- 自旋计算得到的指定位置是否为null,使用CAS在这个位置赋值Segment

- Segment.put插入key,value

final V put(K key, int hash, V value, boolean onlyIfAbsent) {

HashEntry<K,V> node = tryLock() ? null : scanAndLockForPut(key, hash, value);

V oldValue;

try {

HashEntry<K,V>[] tab = table;

int index = (tab.length - 1) & hash;

HashEntry<K,V> first = entryAt(tab, index);

for (HashEntry<K,V> e = first;;) {

if (e != null) {

K k;

if ((k = e.key) == key ||

(e.hash == hash && key.equals(k))) {

oldValue = e.value;

if (!onlyIfAbsent) {

e.value = value;

++modCount;

}

break;

}

e = e.next;

}

else {

if (node != null)

node.setNext(first);

else

node = new HashEntry<K,V>(hash, key, value, first);

int c = count + 1;

if (c > threshold && tab.length < MAXIMUM_CAPACITY)

rehash(node);

else

setEntryAt(tab, index, node);

++modCount;

count = c;

oldValue = null;

break;

}

}

} finally {

unlock();

}

return oldValue;

}

tryLock() 获取锁,获取不到使用 scanAndLockForPut 方法继续获取。

计算 put 的数据要放入的 index 位置,然后获取这个位置上的 HashEntry 。

遍历 put 新元素,为什么要遍历?因为这里获取的 HashEntry 可能是一个空元素,也可能是链表已存在,所以要区别对待。

如果这个位置上的 HashEntry 不存在:

- 如果当前容量大于扩容阀值,小于最大容量,进行扩容。

- 直接头插法插入。

如果这个位置上的 HashEntry 存在:

- 判断链表当前元素 key 和 hash 值是否和要 put 的 key 和 hash 值一致。一致则替换值

- 不一致,获取链表下一个节点,直到发现相同进行值替换,或者链表表里完毕没有相同的。

- 如果当前容量大于扩容阀值,小于最大容量,进行扩容。

- 直接链表头插法插入。

如果要插入的位置之前已经存在,替换后返回旧值,否则返回 null.

resize

扩容使用的是头插法

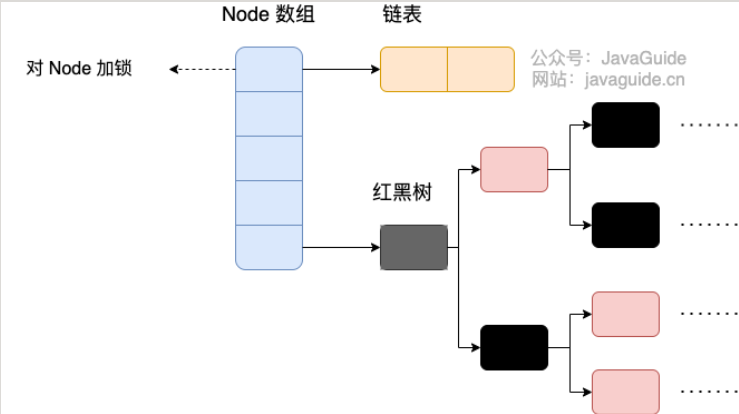

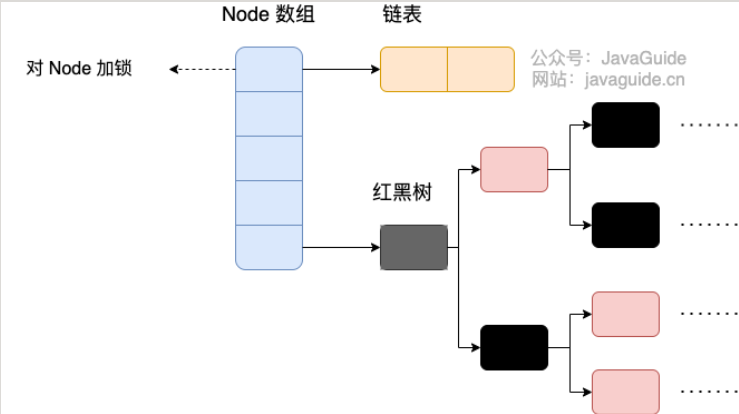

JDK1.8

由原先的Segment数组 + HashEntry转化为Node数组 + 链表/红黑树

重要属性

public class ConcurrentHashMap<K,V> extends AbstractMap<K,V>

implements ConcurrentMap<K,V>, Serializable {

transient volatile Node<K,V>[] table;

private transient volatile Node<K,V>[] nextTable;

private transient volatile long baseCount;

private transient volatile int sizeCtl;

private transient volatile int transferIndex;

private transient volatile int cellsBusy;

private transient volatile CounterCell[] counterCells;

private transient KeySetView<K,V> keySet;

private transient ValuesView<K,V> values;

private transient EntrySetView<K,V> entrySet;

}

Node

基本与HashMap中的相同,所以略过

initTable

初始化

private final Node<K,V>[] initTable() {

Node<K,V>[] tab; int sc;

while ((tab = table) == null || tab.length == 0) {

if ((sc = sizeCtl) < 0)

Thread.yield();

else if (U.compareAndSwapInt(this, SIZECTL, sc, -1)) {

try {

if ((tab = table) == null || tab.length == 0) {

int n = (sc > 0) ? sc : DEFAULT_CAPACITY;

@SuppressWarnings("unchecked")

Node<K,V>[] nt = (Node<K,V>[])new Node<?,?>[n];

table = tab = nt;

sc = n - (n >>> 2);

}

} finally {

sizeCtl = sc;

}

break;

}

}

return tab;

}

- 通过自旋 + CAS操作来完成初始化

- sizeCtl 的值

- -1 : 正在初始化

- N:正在扩容高16位位扩容的标识戳,低16位-1位正在扩容的线程数

- 0 :table初始化大小,如果table没有初始化

0 : 扩容阈值

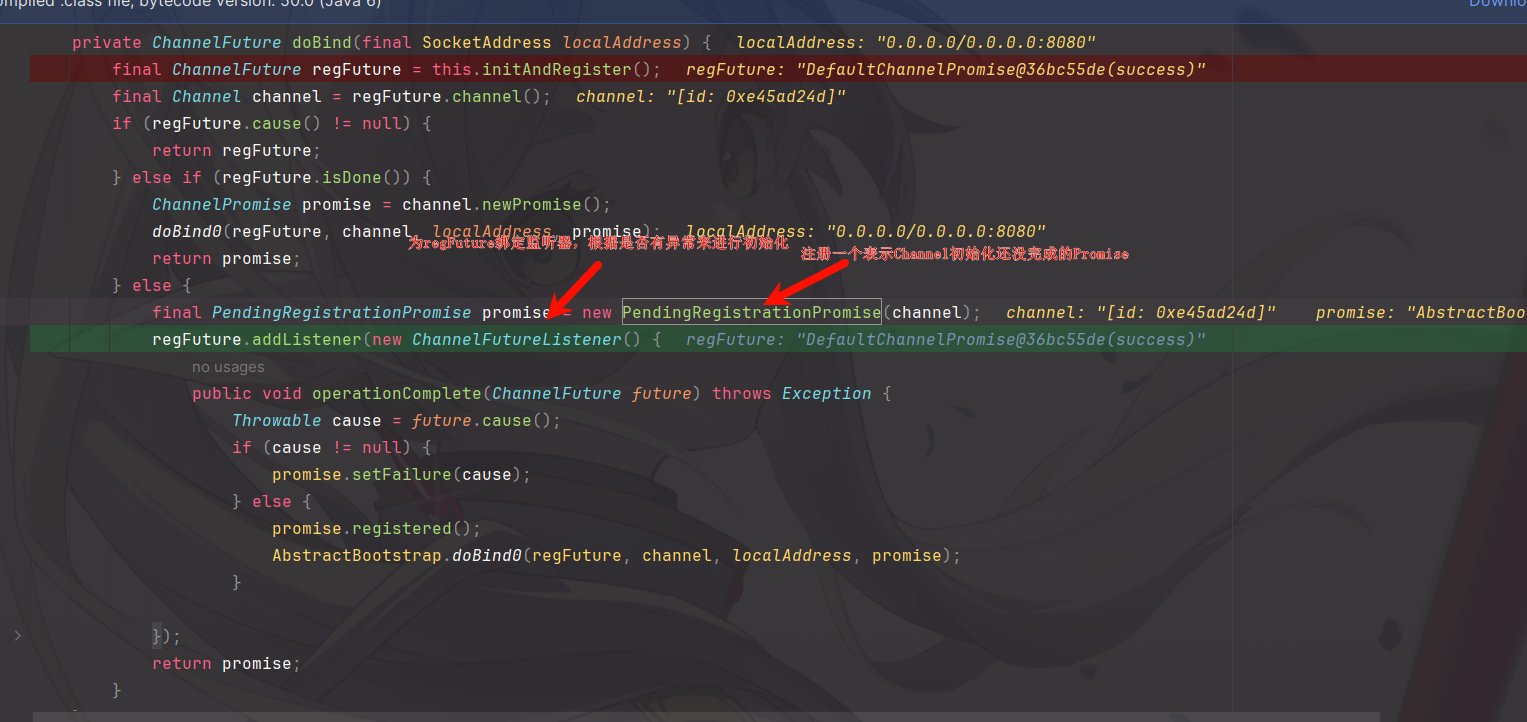

put

public V put(K key, V value) {

return putVal(key, value, false);

}

final V putVal(K key, V value, boolean onlyIfAbsent) {

if (key == null || value == null) throw new NullPointerException();

int hash = spread(key.hashCode());

int binCount = 0;

for (Node<K,V>[] tab = table;;) {

Node<K,V> f; int n, i, fh;

if (tab == null || (n = tab.length) == 0)

tab = initTable();

else if ((f = tabAt(tab, i = (n - 1) & hash)) == null) {

if (casTabAt(tab, i, null,

new Node<K,V>(hash, key, value, null)))

break;

}

else if ((fh = f.hash) == MOVED)

tab = helpTransfer(tab, f);

else {

V oldVal = null;

synchronized (f) {

if (tabAt(tab, i) == f) {

if (fh >= 0) {

binCount = 1;

for (Node<K,V> e = f;; ++binCount) {

K ek;

if (e.hash == hash &&

((ek = e.key) == key ||

(ek != null && key.equals(ek)))) {

oldVal = e.val;

if (!onlyIfAbsent)

e.val = value;

break;

} Node<K,V> pred = e;

if ((e = e.next) == null) {

pred.next = new Node<K,V>(hash, key,

value, null);

break;

} } } else if (f instanceof TreeBin) {

Node<K,V> p;

binCount = 2;

if ((p = ((TreeBin<K,V>)f).putTreeVal(hash, key,

value)) != null) {

oldVal = p.val;

if (!onlyIfAbsent)

p.val = value;

} } } } if (binCount != 0) {

if (binCount >= TREEIFY_THRESHOLD)

treeifyBin(tab, i);

if (oldVal != null)

return oldVal;

break;

} } } addCount(1L, binCount);

return null;

}

- 通过key计算hashcode

- 判断是否需要初始化

- 定位到Node,如果为空直接用CAS写入,失败就自旋保证成功

- 如果hashcode == MOVED == - 1需要进行扩容

- 如果都不满足就使用synchronized锁写入数据

- 如果数量大于TREEIFY_THRESHOLD调用treeifyBin进行转化

值得一提的是synchronized在这里是锁住了这个一个桶,也是这一个Node,而不是一整个表

get

public V get(Object key) {

Node<K,V>[] tab; Node<K,V> e, p; int n, eh; K ek;

int h = spread(key.hashCode());

if ((tab = table) != null && (n = tab.length) > 0 &&

(e = tabAt(tab, (n - 1) & h)) != null) {

if ((eh = e.hash) == h) {

if ((ek = e.key) == key || (ek != null && key.equals(ek)))

return e.val;

}

else if (eh < 0)

return (p = e.find(h, key)) != null ? p.val : null;

while ((e = e.next) != null) {

if (e.hash == h &&

((ek = e.key) == key || (ek != null && key.equals(ek))))

return e.val;

}

}

return null;

}

常见八股

HashMap的底层实现是什么

JDK1.8之前是数组 + 链表,数组是HashMap的主体,链表是用来解决哈希冲突。使用拉链法来解决。

JDK1.8之后变为数组+链表/红黑树,当链表长度大于等于阈值 8 时,会转化,如果当前数组长度小于64就学会先进行数组扩容,否则就转化为红黑树,默认大小为16,每次扩容2倍。

拉链法到底是什么

拉链法就是使用一个链表数组,数组中的每一格都是一个链表,如果遇见哈希冲突,则将冲突的值加到链表中。

JDK1.8之后会先判断链表的长度是否大于阈值8,然后去根据数据来判断是否转化为红黑树。

为什么使用2作为底数

- 使用2作为底数可以使用位运算而不是取模去计算索引,比较方便,提高性能

- 同时容量是2的幂次时,哈希值的低位和高位都可以参与索引的计算,减少哈希冲突(capacity 是 2 的幂次,因此 capacity - 1 的二进制表示全是 1,这样 hash & (capacity - 1) 就能高效地计算出索引。)

- 扩容更更简单,重新计算哈希只需要检查哈希值的一个额外位

讲解一下put的过程

- 判断map是否为空,如果为空或者长度位0就及逆行初始化或者扩容

- 之后计算hash值,去匹配Node数组,如果定位到的数组没有位置为空,则直接插入到Node数组中

- 如果不为空,判断是否是树节点,如果是就调用putTreeVal,否则就去遍历这个数组所对应的链表,如果出现哈希值和key完全一致就覆盖数据,否则就遍历到最后使用尾插法,插入数据

- 插入或者覆盖数据之后判断是否需要扩容或者转化为树形结构

为什么JDK1.8使用尾插法而不是和JDK1.7一样使用头插法

因为多线程的情况头插法有可能会出现环

HashMap何时会扩容

当链表的长度大于TREEIFY_THRESHOLD(默认为8)时会开始转化,同时要判断Node数组的个数是否大于MIN_TREEIFY_CAPACITY(默认64),如果小于就会先进行扩容,而不是转化,如果大于就直接转化为红黑树

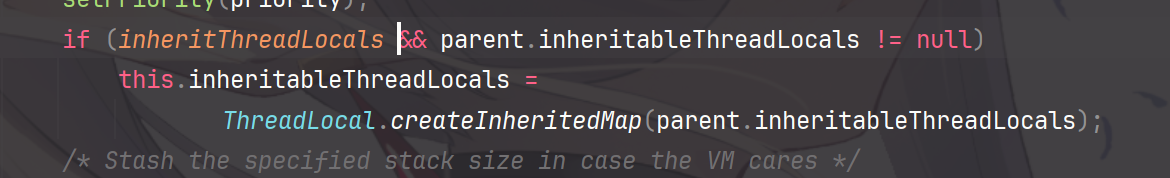

Segment 通过继承 ReentrantLock 来进行加锁

Segment 通过继承 ReentrantLock 来进行加锁

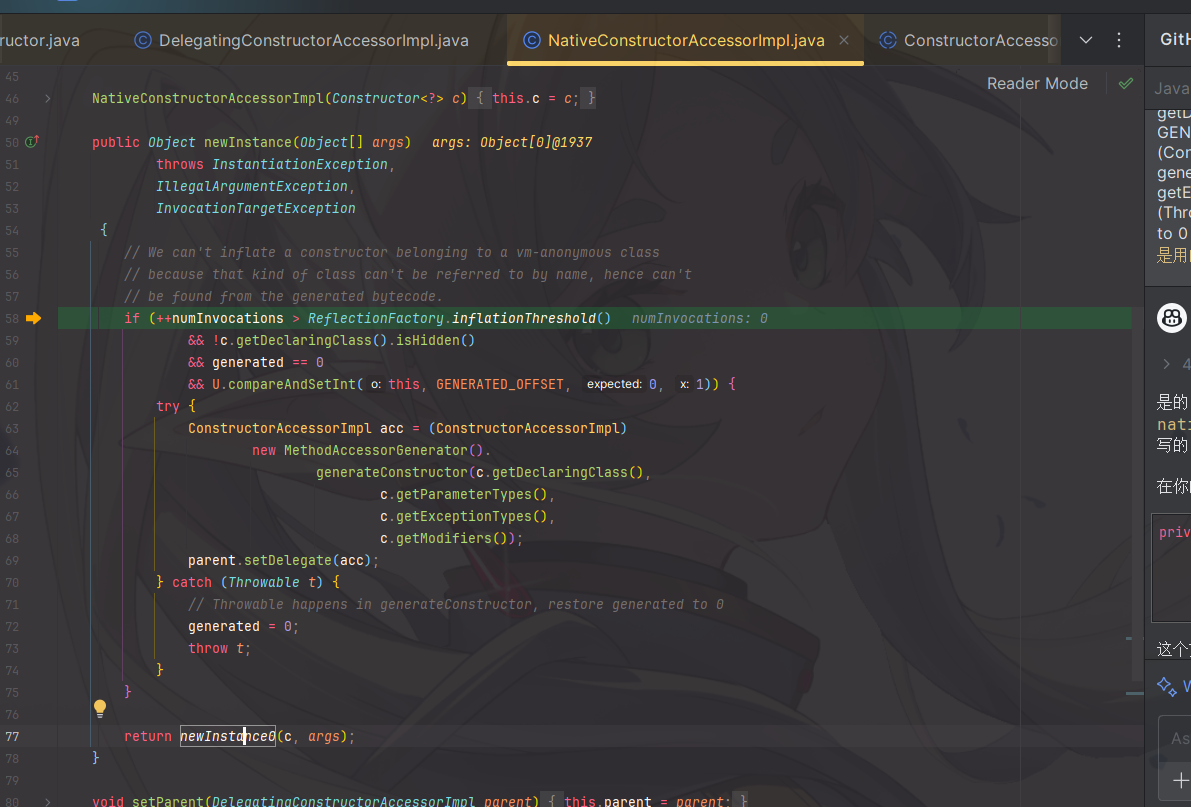

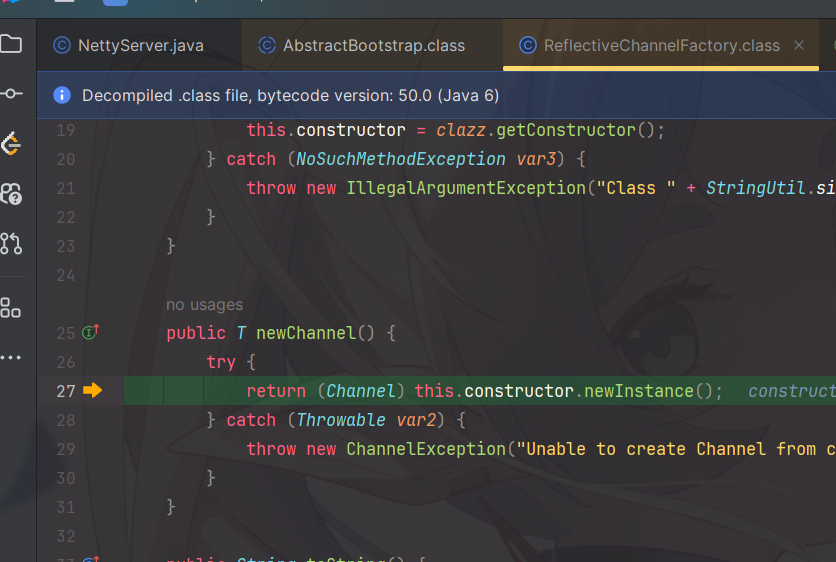

找到了如何初始化的,

找到了如何初始化的,